Lecun团队的第一个开源代码世界模型:它可以生成

日期:2025-10-09 10:19 浏览:

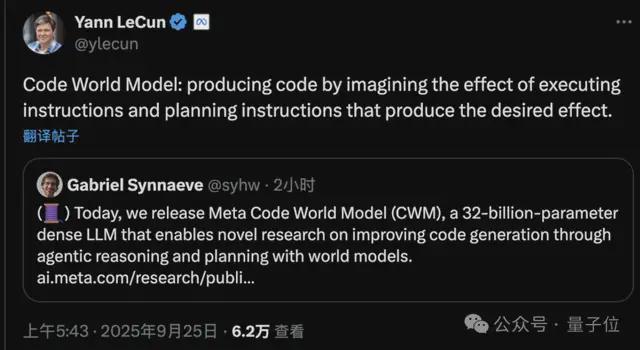

由Aofeisi量子位出版。官方帐户Qbitai刚刚启动了世界代码模型! CWM(代码世界模型)是一种具有32B参数卷和131K令牌上下文大小的详尽语言模型,是一种专门设计用于生成代码和推理的研究模型。这是世界上第一个系统地将世界模型引入代码生成的模型。与现有的代码模型相比,关于CWM的最独特之处在于,它不仅可以产生代码并了解语义。更重要的是,它“知道”如何执行代码,并且可能在代码操作过程中模仿变量的变化和环境反馈,从而促进一般改进的代码理解,传播甚至计划。换句话说,能够在人类的MGA程序员附近思考。 CWM在许多任务和识别任务中都表现出色,例如,它在SWE-Bench中得分为65.8%,这使所有开源源o oF相同规模并接近GPT-4级别的F模型。更重要的是,Meta Fair目前在许多阶段开放了模型代码,培训细节和重量检查站,并且充满了诚实。有人给林肯留下了一条消息:“您不总是认为语言模型只是AI路径上的分支(LLMS是一个关闭的坡道),为什么您为什么根据语言模型启动世界模型?” Lecun很容易回答:是的,但是我们今天在谈论编程,而不是ASI。让大型模型“知道如何执行动态-New” CWM,该CWM直接达到了一代大型模型中的主要疾病点:即使是那些存在Malmodel模型的人也能够编写代码,该代码的实现不稳定,生成的内容的影响也很难删除,毫无疑问,以及隐藏的逻辑错误。博览会团队认为,根本原因是大型模型仅将代码视为文本。它不了解代码如何运行,一个d对可变状态的变化和操作呼叫的影响(甚至无知)有一点了解。查看公平团队:如果您想将模型视为程序员,则应教给它,而代码实施中的“世界各州”变化。因此,CWM在第一次培训中引入了世界的建模概念,显然使该模型可以找到“程序状态如何改变代码操作中的步骤”。这意味着CWM的理解维度已从静态文本转变为改变的实现。科学研究科学家Gabriel Synnaeve专门研究AI和代码生成,以及为CWM做出贡献的高级核心,分享了一个CWM监控和进行代码的实例,该代码计算“草莓”中的“ R”中的数量:您可以将其视为可以在框架初始状态的任何初始状态设置的神经'PDB',可以用作框架初始工具。与S相比代币连接令牌与传统代码模型的质量预测,CWM在三个基本功能方面有所提高。 CWM可以模仿逐行实现代码的过程,猜测每条代码如何影响变量的状态,甚至弯曲提前实施的潜在错误。这种能力提供了开发“神经调试器”的可能性。在CWM推理过程中,可以在代码运行时不断更新可变状态。它还可以模仿整理条件,循环的扩展和边界条件,以准确理解程序的逻辑。其次,自我调试和调整。您不仅可以编写代码,而且CWM还可以测试并修复错误。它可以在制定代码后自动开发测试用例,并尝试在代码失败后使用许多更改的路径进行调整。整个过程模仿了人类程序员通常开发的闭环:写→测试→更改重新测试。 ThIRD,推理和计划能力。当面对Kumplicated问题时,CWM也可以进行理解和计划。例如,在编程竞争或数学工作中,它可以根据问题描述,计划性能结构来研究步骤,然后逐渐生成和验证代码以及实施预测,显示许多逻辑推理能力的细化。 CWM模型信息:参数,体系结构,性能所有CWM模型体系结构使用64层解码器的变压器具有32B比例参数。它支持131k代币的长期环境 - 大大扩展了复杂项目,多文件代码和文档上下文的处理能力。在这方面,注意力结构采用了局部交替机制,捕捉了环境的效率和覆盖范围。博览会提供以下3个检查站,以供研究人员使用:CWM预培训模型:考试PLE,用于新的训练后方法。 CWM SFT:例如,用于增强研究。 CWM:例如,用于扩大理解时间。与许多一线模型相比,CWM标记如下:验证的SWE-Bench分数为65.8%,这导致了所有开放资源模型,并且接近GPT-4级别; LiveCodeBench V5分数为68.6%,显示了高复杂编程活动的准确性; Math-500分数为96.6%,AIME 2024模拟问题高达76.0%;终端板凳得分为26.3%,高于双子座2.5 Pro; Aider Polyglot(多语言代码生成)标记为35.1%,类似于Qwen3-32b。 SA痛苦事实,CWM在许多方面都表现出色,例如理解,产生,验证和组织。博览会团队表示,CWM已证明了“代码世界建模”在改善代码的推理和生成方面的价值。 Gabriel Synnaeve说:我为我的Codegen团队所做的工作感到非常自豪!该小组由Stude医生组成NTS和经验丰富的高级职员。我们所有人都一起工作,尽力而为,永远不要责怪他人的任何问题。整个META AI社区共同努力。非常感谢整个领导力的同样支持。三阶段训练过程在三个阶段进行,包括CWM施工训练 - 第一阶段,训练阶段(预处理)。在此阶段,CWM使用8T数据令牌来进行标准语言培训和建模代码。包括这些内容,代码的成本约为30%,上下文长度为8K令牌。第二阶段是中型训练(中训练)阶段,这也是CWM中最独特的一步。在此阶段,该模型引入了5T世界建模数据,以训练模型,以确定“程序状态在运行代码期间的变化”。主要数据类型的这一部分包括:Python实现轨迹数据来自十数亿个呼叫和代码提交,记录了变量的价值如何变化执行每条代码时;由前码数据模型驱动的代理在真实的Docker环境中运行代码,调整错误,执行任务并生成真正的互连轨迹(总共300万);语言的自然描述的版本是 - 转化实现自然语言的过程,这有助于慷慨和过渡。同样在此阶段,CWM上下文的能力扩展到了131K代币,该代币支持大型项目和代码过程的完整建模。第三阶段,训练阶段(SFT+多任务RL)。最后,CWM对100B令牌和多任务加固学习(RL)培训进行了良好的训练(SFT)。培训任务涵盖了真正的软件工程活动(例如SWE-Bench),编程竞争问题(CodeContests等)和数学推理问题(例如AIME,MATHQA模拟仿真问题)。在这个阶段,他的公平团队使用RL机制,分布式环境和引导程序的程序来提高许多环境和许多活动之间模型的总体通用能力。在基础架构方面,CWM培训使用Flashhattention-3,FSDP+TP并行技术,并使用FP8的低孔隙性。 Meta Fair强调,其训练过程遵循Frontier AI框架中AI安全框架的切割。结果表明,CWM不会带来滥用敏感领域(例如网络安全,化学和生物学)的风险。此外,应注意的是,当前的CWM世界建模数据仅支持Python语言,并且尚未涵盖C ++和Java等基本语言或符号实现。但是,研究小组表示,将来会探索多语言扩展,这将为自动助理助理开发一个共同的框架。另外两件事,如果您想使用CWM,则在那里E需要注意的两个点:首先,CWM主要旨在理解代码和复杂的推理研究,而不会产生RLHF。因此,它不适用于通信任务或聊天机器人。其次,CWM显然被定位为“研究”,也就是说,它仅用于非商业研究。无论如何,CWM团队选择开放资源模型,透明数据和完全开放的培训。它还在研究界提出了一个重要的问题:如果大型模型理解世界,它可以成为更好的程序员吗?

特别声明:上面的内容(包括照片或视频(如果有))已由“ NetEase”自助媒体平台的用户上传和发布。 Nagthis平台只会提供信息存储服务。

注意:上面的内容(包括照片和视频(如果有))已由NetEase Hao用户上传和发布,该用户是社交媒体平台,仅提供信息存储服务。

由Aofeisi量子位出版。官方帐户Qbitai刚刚启动了世界代码模型! CWM(代码世界模型)是一种具有32B参数卷和131K令牌上下文大小的详尽语言模型,是一种专门设计用于生成代码和推理的研究模型。这是世界上第一个系统地将世界模型引入代码生成的模型。与现有的代码模型相比,关于CWM的最独特之处在于,它不仅可以产生代码并了解语义。更重要的是,它“知道”如何执行代码,并且可能在代码操作过程中模仿变量的变化和环境反馈,从而促进一般改进的代码理解,传播甚至计划。换句话说,能够在人类的MGA程序员附近思考。 CWM在许多任务和识别任务中都表现出色,例如,它在SWE-Bench中得分为65.8%,这使所有开源源o oF相同规模并接近GPT-4级别的F模型。更重要的是,Meta Fair目前在许多阶段开放了模型代码,培训细节和重量检查站,并且充满了诚实。有人给林肯留下了一条消息:“您不总是认为语言模型只是AI路径上的分支(LLMS是一个关闭的坡道),为什么您为什么根据语言模型启动世界模型?” Lecun很容易回答:是的,但是我们今天在谈论编程,而不是ASI。让大型模型“知道如何执行动态-New” CWM,该CWM直接达到了一代大型模型中的主要疾病点:即使是那些存在Malmodel模型的人也能够编写代码,该代码的实现不稳定,生成的内容的影响也很难删除,毫无疑问,以及隐藏的逻辑错误。博览会团队认为,根本原因是大型模型仅将代码视为文本。它不了解代码如何运行,一个d对可变状态的变化和操作呼叫的影响(甚至无知)有一点了解。查看公平团队:如果您想将模型视为程序员,则应教给它,而代码实施中的“世界各州”变化。因此,CWM在第一次培训中引入了世界的建模概念,显然使该模型可以找到“程序状态如何改变代码操作中的步骤”。这意味着CWM的理解维度已从静态文本转变为改变的实现。科学研究科学家Gabriel Synnaeve专门研究AI和代码生成,以及为CWM做出贡献的高级核心,分享了一个CWM监控和进行代码的实例,该代码计算“草莓”中的“ R”中的数量:您可以将其视为可以在框架初始状态的任何初始状态设置的神经'PDB',可以用作框架初始工具。与S相比代币连接令牌与传统代码模型的质量预测,CWM在三个基本功能方面有所提高。 CWM可以模仿逐行实现代码的过程,猜测每条代码如何影响变量的状态,甚至弯曲提前实施的潜在错误。这种能力提供了开发“神经调试器”的可能性。在CWM推理过程中,可以在代码运行时不断更新可变状态。它还可以模仿整理条件,循环的扩展和边界条件,以准确理解程序的逻辑。其次,自我调试和调整。您不仅可以编写代码,而且CWM还可以测试并修复错误。它可以在制定代码后自动开发测试用例,并尝试在代码失败后使用许多更改的路径进行调整。整个过程模仿了人类程序员通常开发的闭环:写→测试→更改重新测试。 ThIRD,推理和计划能力。当面对Kumplicated问题时,CWM也可以进行理解和计划。例如,在编程竞争或数学工作中,它可以根据问题描述,计划性能结构来研究步骤,然后逐渐生成和验证代码以及实施预测,显示许多逻辑推理能力的细化。 CWM模型信息:参数,体系结构,性能所有CWM模型体系结构使用64层解码器的变压器具有32B比例参数。它支持131k代币的长期环境 - 大大扩展了复杂项目,多文件代码和文档上下文的处理能力。在这方面,注意力结构采用了局部交替机制,捕捉了环境的效率和覆盖范围。博览会提供以下3个检查站,以供研究人员使用:CWM预培训模型:考试PLE,用于新的训练后方法。 CWM SFT:例如,用于增强研究。 CWM:例如,用于扩大理解时间。与许多一线模型相比,CWM标记如下:验证的SWE-Bench分数为65.8%,这导致了所有开放资源模型,并且接近GPT-4级别; LiveCodeBench V5分数为68.6%,显示了高复杂编程活动的准确性; Math-500分数为96.6%,AIME 2024模拟问题高达76.0%;终端板凳得分为26.3%,高于双子座2.5 Pro; Aider Polyglot(多语言代码生成)标记为35.1%,类似于Qwen3-32b。 SA痛苦事实,CWM在许多方面都表现出色,例如理解,产生,验证和组织。博览会团队表示,CWM已证明了“代码世界建模”在改善代码的推理和生成方面的价值。 Gabriel Synnaeve说:我为我的Codegen团队所做的工作感到非常自豪!该小组由Stude医生组成NTS和经验丰富的高级职员。我们所有人都一起工作,尽力而为,永远不要责怪他人的任何问题。整个META AI社区共同努力。非常感谢整个领导力的同样支持。三阶段训练过程在三个阶段进行,包括CWM施工训练 - 第一阶段,训练阶段(预处理)。在此阶段,CWM使用8T数据令牌来进行标准语言培训和建模代码。包括这些内容,代码的成本约为30%,上下文长度为8K令牌。第二阶段是中型训练(中训练)阶段,这也是CWM中最独特的一步。在此阶段,该模型引入了5T世界建模数据,以训练模型,以确定“程序状态在运行代码期间的变化”。主要数据类型的这一部分包括:Python实现轨迹数据来自十数亿个呼叫和代码提交,记录了变量的价值如何变化执行每条代码时;由前码数据模型驱动的代理在真实的Docker环境中运行代码,调整错误,执行任务并生成真正的互连轨迹(总共300万);语言的自然描述的版本是 - 转化实现自然语言的过程,这有助于慷慨和过渡。同样在此阶段,CWM上下文的能力扩展到了131K代币,该代币支持大型项目和代码过程的完整建模。第三阶段,训练阶段(SFT+多任务RL)。最后,CWM对100B令牌和多任务加固学习(RL)培训进行了良好的训练(SFT)。培训任务涵盖了真正的软件工程活动(例如SWE-Bench),编程竞争问题(CodeContests等)和数学推理问题(例如AIME,MATHQA模拟仿真问题)。在这个阶段,他的公平团队使用RL机制,分布式环境和引导程序的程序来提高许多环境和许多活动之间模型的总体通用能力。在基础架构方面,CWM培训使用Flashhattention-3,FSDP+TP并行技术,并使用FP8的低孔隙性。 Meta Fair强调,其训练过程遵循Frontier AI框架中AI安全框架的切割。结果表明,CWM不会带来滥用敏感领域(例如网络安全,化学和生物学)的风险。此外,应注意的是,当前的CWM世界建模数据仅支持Python语言,并且尚未涵盖C ++和Java等基本语言或符号实现。但是,研究小组表示,将来会探索多语言扩展,这将为自动助理助理开发一个共同的框架。另外两件事,如果您想使用CWM,则在那里E需要注意的两个点:首先,CWM主要旨在理解代码和复杂的推理研究,而不会产生RLHF。因此,它不适用于通信任务或聊天机器人。其次,CWM显然被定位为“研究”,也就是说,它仅用于非商业研究。无论如何,CWM团队选择开放资源模型,透明数据和完全开放的培训。它还在研究界提出了一个重要的问题:如果大型模型理解世界,它可以成为更好的程序员吗?

特别声明:上面的内容(包括照片或视频(如果有))已由“ NetEase”自助媒体平台的用户上传和发布。 Nagthis平台只会提供信息存储服务。

注意:上面的内容(包括照片和视频(如果有))已由NetEase Hao用户上传和发布,该用户是社交媒体平台,仅提供信息存储服务。

由Aofeisi量子位出版。官方帐户Qbitai刚刚启动了世界代码模型! CWM(代码世界模型)是一种具有32B参数卷和131K令牌上下文大小的详尽语言模型,是一种专门设计用于生成代码和推理的研究模型。这是世界上第一个系统地将世界模型引入代码生成的模型。与现有的代码模型相比,关于CWM的最独特之处在于,它不仅可以产生代码并了解语义。更重要的是,它“知道”如何执行代码,并且可能在代码操作过程中模仿变量的变化和环境反馈,从而促进一般改进的代码理解,传播甚至计划。换句话说,能够在人类的MGA程序员附近思考。 CWM在许多任务和识别任务中都表现出色,例如,它在SWE-Bench中得分为65.8%,这使所有开源源o oF相同规模并接近GPT-4级别的F模型。更重要的是,Meta Fair目前在许多阶段开放了模型代码,培训细节和重量检查站,并且充满了诚实。有人给林肯留下了一条消息:“您不总是认为语言模型只是AI路径上的分支(LLMS是一个关闭的坡道),为什么您为什么根据语言模型启动世界模型?” Lecun很容易回答:是的,但是我们今天在谈论编程,而不是ASI。让大型模型“知道如何执行动态-New” CWM,该CWM直接达到了一代大型模型中的主要疾病点:即使是那些存在Malmodel模型的人也能够编写代码,该代码的实现不稳定,生成的内容的影响也很难删除,毫无疑问,以及隐藏的逻辑错误。博览会团队认为,根本原因是大型模型仅将代码视为文本。它不了解代码如何运行,一个d对可变状态的变化和操作呼叫的影响(甚至无知)有一点了解。查看公平团队:如果您想将模型视为程序员,则应教给它,而代码实施中的“世界各州”变化。因此,CWM在第一次培训中引入了世界的建模概念,显然使该模型可以找到“程序状态如何改变代码操作中的步骤”。这意味着CWM的理解维度已从静态文本转变为改变的实现。科学研究科学家Gabriel Synnaeve专门研究AI和代码生成,以及为CWM做出贡献的高级核心,分享了一个CWM监控和进行代码的实例,该代码计算“草莓”中的“ R”中的数量:您可以将其视为可以在框架初始状态的任何初始状态设置的神经'PDB',可以用作框架初始工具。与S相比代币连接令牌与传统代码模型的质量预测,CWM在三个基本功能方面有所提高。 CWM可以模仿逐行实现代码的过程,猜测每条代码如何影响变量的状态,甚至弯曲提前实施的潜在错误。这种能力提供了开发“神经调试器”的可能性。在CWM推理过程中,可以在代码运行时不断更新可变状态。它还可以模仿整理条件,循环的扩展和边界条件,以准确理解程序的逻辑。其次,自我调试和调整。您不仅可以编写代码,而且CWM还可以测试并修复错误。它可以在制定代码后自动开发测试用例,并尝试在代码失败后使用许多更改的路径进行调整。整个过程模仿了人类程序员通常开发的闭环:写→测试→更改重新测试。 ThIRD,推理和计划能力。当面对Kumplicated问题时,CWM也可以进行理解和计划。例如,在编程竞争或数学工作中,它可以根据问题描述,计划性能结构来研究步骤,然后逐渐生成和验证代码以及实施预测,显示许多逻辑推理能力的细化。 CWM模型信息:参数,体系结构,性能所有CWM模型体系结构使用64层解码器的变压器具有32B比例参数。它支持131k代币的长期环境 - 大大扩展了复杂项目,多文件代码和文档上下文的处理能力。在这方面,注意力结构采用了局部交替机制,捕捉了环境的效率和覆盖范围。博览会提供以下3个检查站,以供研究人员使用:CWM预培训模型:考试PLE,用于新的训练后方法。 CWM SFT:例如,用于增强研究。 CWM:例如,用于扩大理解时间。与许多一线模型相比,CWM标记如下:验证的SWE-Bench分数为65.8%,这导致了所有开放资源模型,并且接近GPT-4级别; LiveCodeBench V5分数为68.6%,显示了高复杂编程活动的准确性; Math-500分数为96.6%,AIME 2024模拟问题高达76.0%;终端板凳得分为26.3%,高于双子座2.5 Pro; Aider Polyglot(多语言代码生成)标记为35.1%,类似于Qwen3-32b。 SA痛苦事实,CWM在许多方面都表现出色,例如理解,产生,验证和组织。博览会团队表示,CWM已证明了“代码世界建模”在改善代码的推理和生成方面的价值。 Gabriel Synnaeve说:我为我的Codegen团队所做的工作感到非常自豪!该小组由Stude医生组成NTS和经验丰富的高级职员。我们所有人都一起工作,尽力而为,永远不要责怪他人的任何问题。整个META AI社区共同努力。非常感谢整个领导力的同样支持。三阶段训练过程在三个阶段进行,包括CWM施工训练 - 第一阶段,训练阶段(预处理)。在此阶段,CWM使用8T数据令牌来进行标准语言培训和建模代码。包括这些内容,代码的成本约为30%,上下文长度为8K令牌。第二阶段是中型训练(中训练)阶段,这也是CWM中最独特的一步。在此阶段,该模型引入了5T世界建模数据,以训练模型,以确定“程序状态在运行代码期间的变化”。主要数据类型的这一部分包括:Python实现轨迹数据来自十数亿个呼叫和代码提交,记录了变量的价值如何变化执行每条代码时;由前码数据模型驱动的代理在真实的Docker环境中运行代码,调整错误,执行任务并生成真正的互连轨迹(总共300万);语言的自然描述的版本是 - 转化实现自然语言的过程,这有助于慷慨和过渡。同样在此阶段,CWM上下文的能力扩展到了131K代币,该代币支持大型项目和代码过程的完整建模。第三阶段,训练阶段(SFT+多任务RL)。最后,CWM对100B令牌和多任务加固学习(RL)培训进行了良好的训练(SFT)。培训任务涵盖了真正的软件工程活动(例如SWE-Bench),编程竞争问题(CodeContests等)和数学推理问题(例如AIME,MATHQA模拟仿真问题)。在这个阶段,他的公平团队使用RL机制,分布式环境和引导程序的程序来提高许多环境和许多活动之间模型的总体通用能力。在基础架构方面,CWM培训使用Flashhattention-3,FSDP+TP并行技术,并使用FP8的低孔隙性。 Meta Fair强调,其训练过程遵循Frontier AI框架中AI安全框架的切割。结果表明,CWM不会带来滥用敏感领域(例如网络安全,化学和生物学)的风险。此外,应注意的是,当前的CWM世界建模数据仅支持Python语言,并且尚未涵盖C ++和Java等基本语言或符号实现。但是,研究小组表示,将来会探索多语言扩展,这将为自动助理助理开发一个共同的框架。另外两件事,如果您想使用CWM,则在那里E需要注意的两个点:首先,CWM主要旨在理解代码和复杂的推理研究,而不会产生RLHF。因此,它不适用于通信任务或聊天机器人。其次,CWM显然被定位为“研究”,也就是说,它仅用于非商业研究。无论如何,CWM团队选择开放资源模型,透明数据和完全开放的培训。它还在研究界提出了一个重要的问题:如果大型模型理解世界,它可以成为更好的程序员吗?

特别声明:上面的内容(包括照片或视频(如果有))已由“ NetEase”自助媒体平台的用户上传和发布。 Nagthis平台只会提供信息存储服务。

注意:上面的内容(包括照片和视频(如果有))已由NetEase Hao用户上传和发布,该用户是社交媒体平台,仅提供信息存储服务。